分类:Bert相关材料

来自Big Physics

Luohuiying(讨论 | 贡献)2021年11月15日 (一) 16:08的版本

Bert

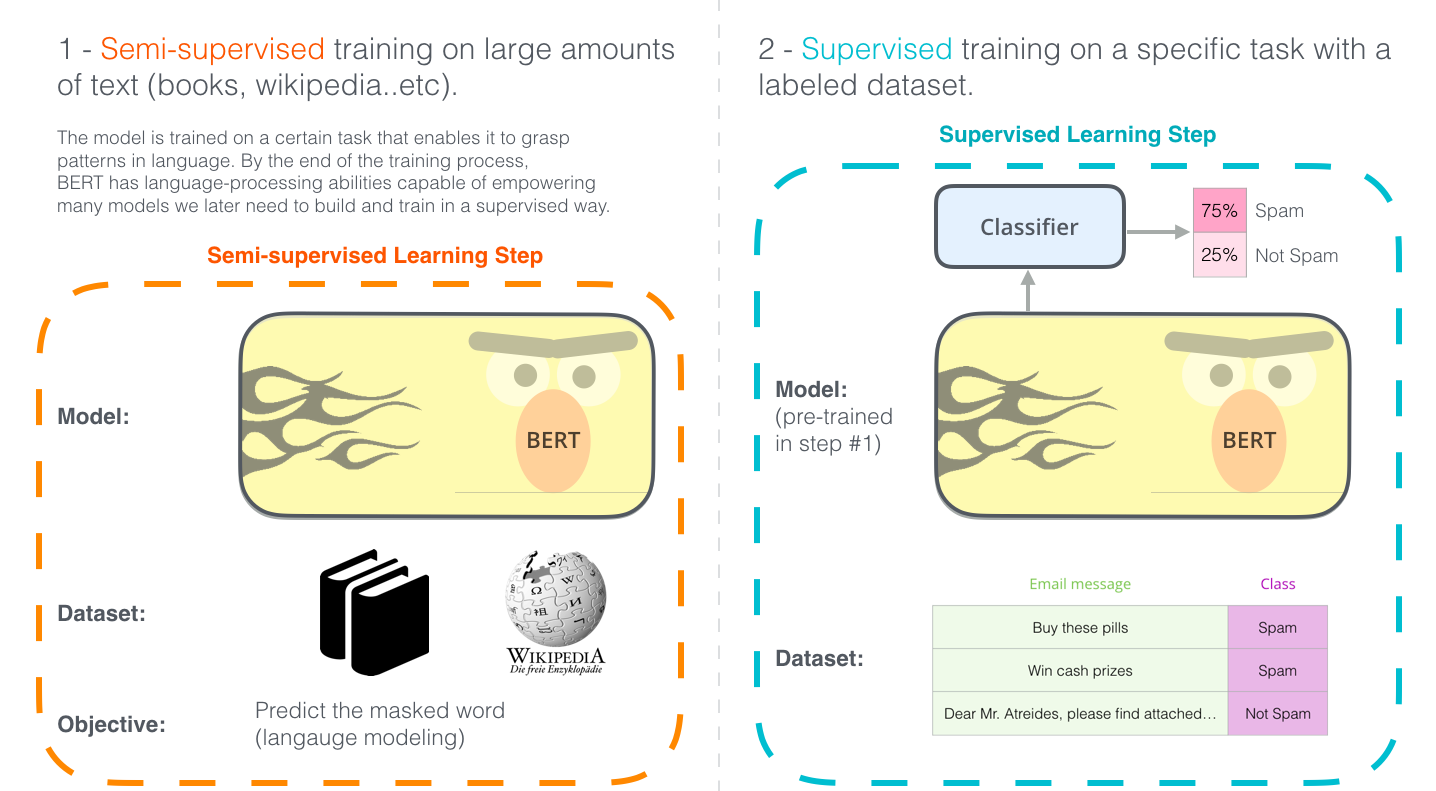

基于变换器的双向编码器表示技术(Bidirectional Encoder Representations from Transformers,BERT)是用于自然语言处理(NLP)的预训练技术,由Google提出。2018年,雅各布·德夫林和同事创建并发布了BERT。Google正在利用BERT来更好地理解用户搜索语句的语义。

最初的英语BERT发布时提供两种类型的预训练模型:(1)BERTBASE模型,一个12层,768维,12个自注意头(self attention head),110M参数的神经网络结构;(2)BERTLARGE模型,一个24层,1024维,16个自注意头,340M参数的神经网络结构。两者的训练语料都是BooksCorpus以及英语维基百科语料,单词量分别是8亿以及25亿。

模型架构

1.总体架构

本分类目前不含有任何页面或媒体文件。