分类:SciBERT: A Pretrained Language Model for Scientific Text

Iz Beltagy, Kyle Lo, Arman Cohan. SciBERT: A Pretrained Language Model for Scientific Text. EMNLP/IJCNLP 2019

作者识别

作者识别好之后,当做每一篇文献的一个分类标记。

Abstract

Obtaining large-scale annotated data for NLP tasks in the scientific domain is challenging and expensive. We release SciBERT, a pretrained language model based on BERT (Devlin et. al., 2018) to address the lack of high-quality, large-scale labeled scientific data. SciBERT leverages unsupervised pretraining on a large multi-domain corpus of scientific publications to improve performance on downstream scientific NLP tasks. We evaluate on a suite of tasks including sequence tagging, sentence classification and dependency parsing, with datasets from a variety of scientific domains. We demonstrate statistically significant improvements over BERT and achieve new state-of-the-art results on several of these tasks. The code and pretrained models are available at https://github.com/allenai/scibert/.

赞或者踩

表达读者的意见,最好还有一句话来解释这个意见。

总结和评论

问WHWM:说了什么,怎么说的,为什么说这个为什么这样说,对我有什么意义我觉得怎么样

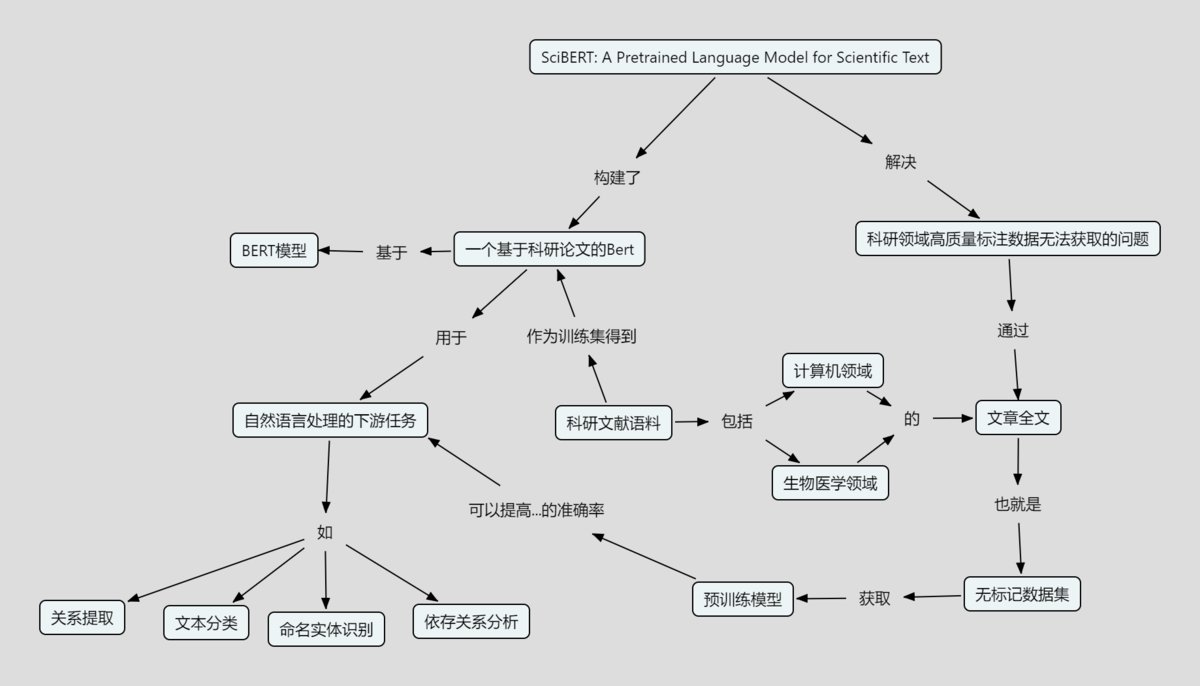

这篇文章为了解决科研领域的高质量标注数据难以获取的问题,对Bert模型进行改进,提出了一个基于科研文献的,在多种科学语料库上进行过训练的预训练语言模型,可以执行不同的下游科学NLP任务的Bert预训练模型(SciBERT).

首先,在词汇表上,选择的是StencepiecesLibrary,(是一个不依赖句子逻辑的词汇表),并且发现科研领域的词汇表和已发布的Bert模型的词汇表的重叠部分仅为40%,这说明科研领域在常用词上科研领域与其他一般领域有着很大的不同。

其次,文章所选择的训练集来自Semantic Schoolar,其中包括了18%的计算机领域,82%的生物医学领域的文章,在进行模型输入的时候,使用的是全文。下游任务有NER,PICO,CLS,REL,DEP。结果分为三个部分:生物医学领域,计算机科学领域和多个领域。 高层结果显示,SCIBERT在科学文本方面的表现优于BERT-Base,并在许多下游任务上实现了新的SOTA

这个基于科学文章数据集的预训练BERT模型的提出有非常大的参考价值,为很多下游的自然语言处理技术提供了便利,也提供了一个数据获取的方式。

SciBert和Bert有什么区别?

SciBERT有自己的词库SCIVOCAB,该词库完全匹配训练语料库 词汇表使用的是科学词汇(SCIVOCAB),Bert基于新闻和Wikipedia. 经过科学语料库的训练。 其余框架和训练方式都一样。

这篇文章与综述文献识别?

确实在idea上拥有着一定的相似度,我们也想用自然语言处理的方式来解决标注数据的问题,所以想要训练出一个用于综述文献识别的分类器,但是我们这个特定分类任务的分类器还没完全优化完成,别人的更一般性的通用的预训练模型就已经发布了。

还可以怎么做?

更进一步的,我们可以把bert模型运用在不只是文本形式的内容上,比如参考文献(甚至是参考文献网络),作者识别,概念地图生成上,吴老师在分类:用于文章主题识别等任务的自然语言处理技术中已经提出了这一使用自然语言处理技术进行处理的方法。 比如,我们把全文信息替换为参考文献信息,对引用的文献进行编号,把这些转换为矢量输入bert模型,是否能够得到一些有意思的结论。或者是参考文献的网络,这揭示了同时引用这篇参考文献的文章数,看哪些文章是经常同时出现的。然后把参考文献的网络转换成矢量输入,构建bert模型。或者,用bert进行作者的识别,看bert是不是能够提取出一个作者在行文时的领域特征或者撰写文献时的一些风格特征。进一步,概念地图是不是也能够用bert进行建模。我们知道对于概念地图中的概念,往往在概念地图中往前走一个概念在文本中通常就要跨越几行或者一个段落,这个时候就可以看出bert是不是能够从输入的数据中学习到概念的学习生成方法,如果没有,那我们是不是可以在bert模型构建的时候,对已经训练好的模型进行封装,同时从外部给定一个概念学习的模式,来进行概念地图的生成。nlp技术的发展给科学学的进一步推进提供了工具,我们也可以运用这些工具,进行一些更拓展的思考。

概念地图

本文工作在哪个概念上,用了什么概念,主要贡献了哪些新概念、新联系。

参考文献

本文重要参考文献

区别本文的所有参考文献,选择其中最重要的少量几篇。

和本文有关的非本文的参考文献

拓展到本文的参考文献之外,本领域和本文紧密相关的论文

本分类目前不含有任何页面或媒体文件。