分类:SPECTER: Document-level Representation Learning using Citation-informed Transformers

Arman Cohan, Sergey Feldman, Iz Beltagy, Doug Downey, Daniel S. Weld, Document-level Representation Learning using Citation-informed Transformers. arXiv:2004.07180v1

Abstract

Abstract Representation learning is a critical ingredient for natural language processing systems. Recent Transformer language models like BERT learn powerful textual representations, but these models are targeted towards token- and sentence-level training objectives and do not leverage information on inter-document relatedness, which limits their document-level representation power. For applications on scientific documents, such as classification and recommendation, the embeddings power strong performance on end tasks. We propose SPECTER, a new method to generate document-level embedding of scientific documents based on pretraining a Transformer language model on a powerful signal of document-level relatedness: the citation graph. Unlike existing pretrained language models, SPECTER can be easily applied to downstream applications without task-specific fine-tuning. Additionally, to encourage further research on document-level models, we introduce SCIDOCS, a new evaluation benchmark consisting of seven document-level tasks ranging from citation prediction, to document classification and recommendation. We show that SPECTER outperforms a variety of competitive baselines on the benchmark.

总结和评论

这个工作[1]把用于词汇和篇章矢量的自然语言模型BERT(拓展之前也有一个把BERT迁移到学术论文的工作SciBERT[2])做了一个小小的拓展,用来包含论文引用关系意义上的相似性。其具体做法是,在矢量表示的目标函数上,引入一个Loss函数,而这个函数保证了具有施引关系的论文之间具有比较大的相似性,没有引用关系的论文之间具有比较小的相似性。

同时,这个论文用了几个数据集,做了几个用这个矢量来处理的后期任务,以及对后期任务做了评价。例如论文聚类、引用关系检验等等任务。除了上面这个词汇篇章和引用关系结合的思路,这篇论文还有数据、评价数据等多个可以参考的方面。更多资源可参考这篇论文的github站点[3]。

这篇论文并没有直接用引文网络来训练论文之间的相似性,而是仅仅通过加入基于引用关系的相似性的目标函数的方式来调整从词汇篇章训练出来的论文矢量。这当然也可以说是一个优点——训练素材不需要引文网络,只需要词汇篇章。

实际上,我们在做的研究,全文(篇章、词汇、参考文献当做词汇、作者当做词汇、学术机构当做词汇)结合参考文献网络上的表示,比这个研究在思路上要先进很多。更多这个研究的信息,可见用于文章主题识别等任务的自然语言处理技术。

——————————————————————————————————————————————————————————————————————————————————————————————————————————-

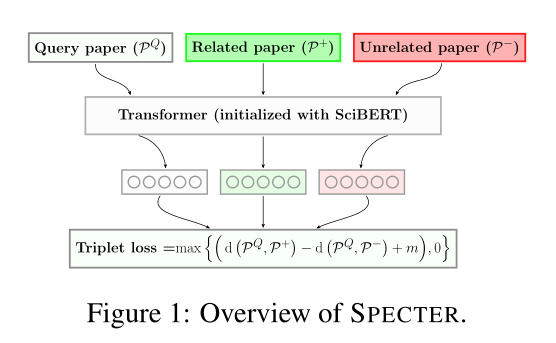

该文章提出了一种引入了文档间相关性的进行文章矢量表示的方法,并使用NLP中的下游任务对模型的有效性进行评估。作者认为在现有的语言模型,如Bert等在进行矢量表示时都仅考虑了文档内上下文的信息而没有考虑文档间的相关性。文章指出,一篇文章引用了另一篇文章,则表示它们是相关的,并且设计了一个损失函数来表示这种相关,这个损失函数使得有引用关系的文章相关性更大,没有引用关系的文章之间的相关性较小。整个模型的思路是:首先输入当前文章,负采样文章,正采样文章的摘要和标题,经过SciBert的框架讲文章转换成了向量的表示,在目标函数上加上一个损失函数来进行相似性的计算。具体的模型图为

每一个训练的实例是一个三元组:当前文章,文章的正采样和文章的负采样。(正采样表示当前文章引用的文章,负采样是当前文章没有引用。)Loss函数为:![]() ,其中d是距离函数,m是超参数。)

,其中d是距离函数,m是超参数。)

负采样的选择负采样分为简单负采样和"hard negatives",简单负采样是从当前文章中未引用的文章中随机选择的。"Hard Negatives"是指一篇文章没有被当前文章所引用,但是被当前文章所引用的文章引用了。如p1引用了p2,p2引用了p3,但是p1没有应用p3,那么p3是p1的负采样的一个例子。

SPECTER模型使用的训练数据是Semantic Schoolar的子集,对于每篇论文都构建了5个三元组,其中2个Hard negatives,三个easy negatives。

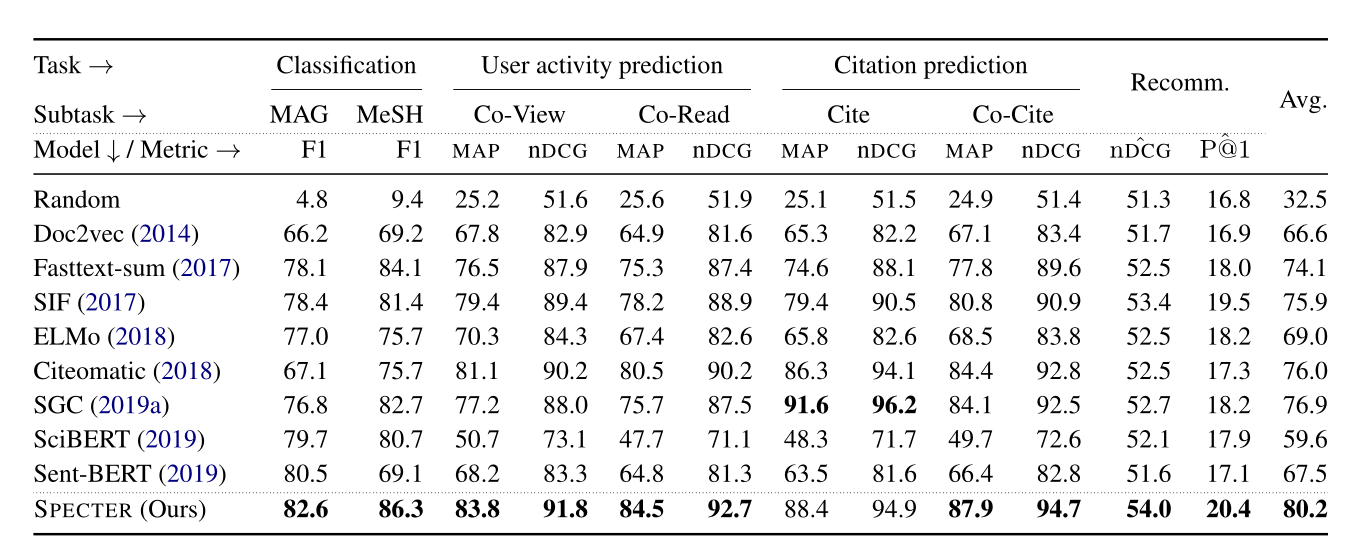

结果展示了使用SPECTER模型训练出的文章向量在下游任务的表现,下游任务有:分类,引用关系识别,推荐任务等。

可以看出几乎在每一个下游任务上的表现都优于之前的语言模型。图中同时也展示了本文基于SCIDOCS数据集构建的SCIDOCS评价体系。

其他发现

作者发现从文本输入中删除摘要并仅依赖标题会导致性能大幅下降,添加作者作为输入(以及标题和摘要)会损害模型性能,推断一种可能的解释是,作者姓名在语料库中很少见,这使得模型很难从中推断文章间的相关性,另一个可能原因是,对于作者姓名来说,使用Wordpieces进行分词不太理想。许多作者的名字超出了SciBERT的词汇表,因此,他们可能会被分词,形成了噪音。添加地点会略微降低性能,除了文档分类(这很有意义,因为我们希望地点与论文主题有很高的相关性)。

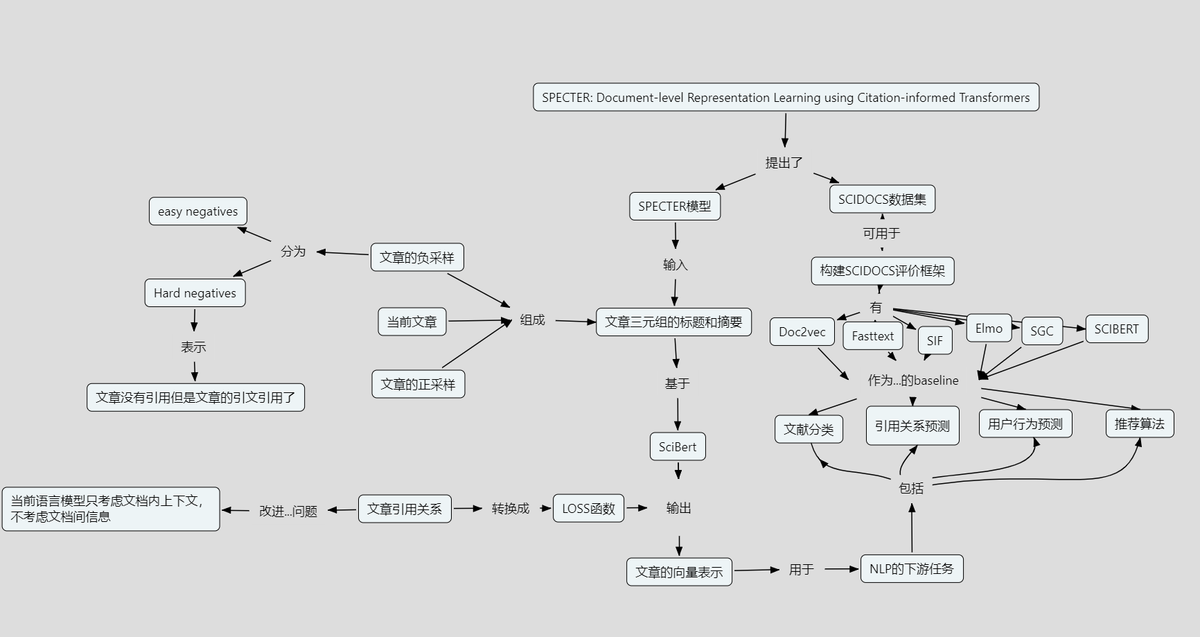

概念地图

参考文献

- ↑ Arman Cohan, Sergey Feldman, Iz Beltagy, Doug Downey, Daniel S. Weld, Document-level Representation Learning using Citation-informed Transformers. https://arxiv.org/abs/2004.07180v1

- ↑ Iz Beltagy, Kyle Lo, and Arman Cohan. 2019. SciBERT: A Pretrained Language Model for Scientific Text. In EMNLP.

- ↑ https://github.com/allenai/specter.

本分类目前不含有任何页面或媒体文件。